En un ecosistema digital cada vez más globalizado, hiperconectado y expuesto, el contenido visual y textual que una marca o comunidad publica no solo representa su identidad, sino que también puede desencadenar consecuencias significativas en términos de percepción pública, sensibilidad cultural e incluso repercusiones legales. Lo que una organización comunica —intencionadamente o no— puede influir en su reputación, credibilidad y relación con sus públicos. Por eso, identificar y filtrar de forma temprana contenido ofensivo, inapropiado o potencialmente sensible se ha convertido en una necesidad estratégica, tanto para empresas como para organizaciones sociales o sin ánimo de lucro.

Conscientes de esta realidad, en hiberus hemos desarrollado un sistema de moderación de contenido basado en inteligencia artificial, capaz de proteger de forma proactiva a entidades del ámbito empresarial y del tercer sector frente a los riesgos derivados de la exposición digital.

Qué hemos construido

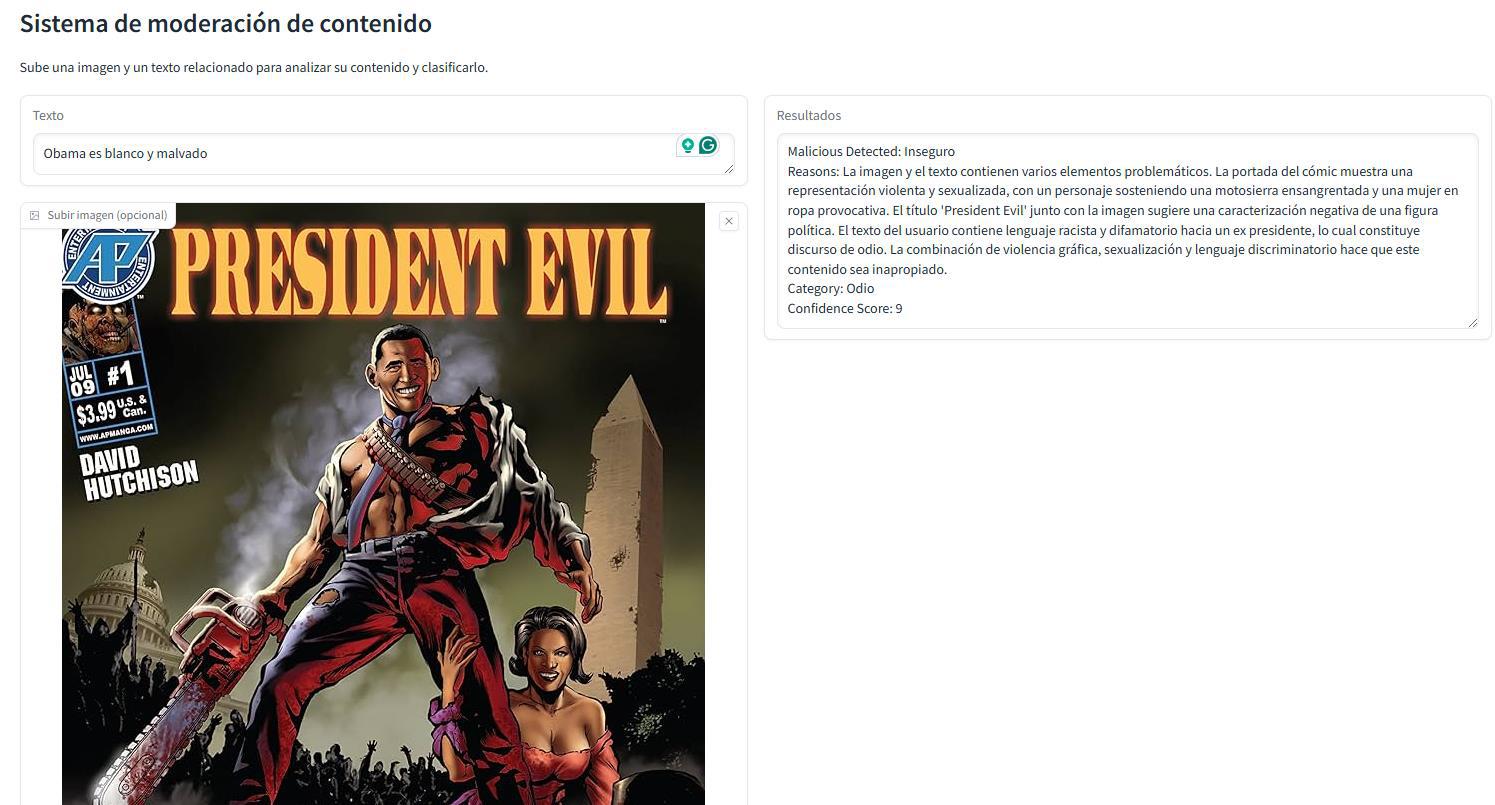

Hemos diseñado y desplegado una plataforma de moderación multimodal, capaz de analizar de forma automatizada tanto imágenes como textos antes de que se publiquen. Gracias a su enfoque basado en modelos de inteligencia artificial avanzados, el sistema puede detectar contenido problemático con un alto nivel de precisión, operando en tiempo real o mediante procesamiento por lotes.

Entre las capacidades de detección más destacadas se incluyen:

-

Presencia de armas, simbología violenta o imágenes explícitamente agresivas.

-

Representaciones religiosas o elementos culturales sensibles fuera de contexto.

-

Discursos de odio, mensajes xenófobos o incitación a la violencia.

-

Lenguaje discriminatorio por razones de género, raza, orientación sexual, religión u origen.

-

Contenidos sexualizados, inapropiados o que vulneran códigos éticos.

Además, la solución es altamente flexible y se puede integrar en múltiples canales digitales, incluyendo plataformas de comercio electrónico, foros comunitarios, redes sociales, chatbots, buzones de sugerencias, sistemas de reseñas y más.

Casos de uso

Ya hemos aplicado esta tecnología con éxito en distintos sectores, demostrando su escalabilidad y eficacia:

🛍️ Retail internacional: realizamos el análisis automatizado de más de 30.000 imágenes cada semana en catálogos digitales, marketplaces y campañas de publicidad, con el objetivo de evitar la publicación de elementos ofensivos, malinterpretables o culturalmente inadecuados.

🌍 ONGs y plataformas sociales: ayudamos a moderar contenido generado por usuarios (UGC) en comunidades digitales abiertas, garantizando que los espacios virtuales sean respetuosos, inclusivos y seguros para todos los participantes.

Estos casos demuestran que, más allá del sector, existe una demanda creciente por soluciones tecnológicas que prevengan crisis reputacionales y fomenten entornos digitales saludables.

Cómo funciona

Nuestra solución combina distintas tecnologías de inteligencia artificial, visión por computador, procesamiento de lenguaje natural (PLN) y servicios cloud. El sistema está compuesto por los siguientes componentes clave:

-

BLIP: modelo lenguaje-visión que genera descripciones automáticas de imágenes y responde preguntas sobre contenido visual.

-

YOLO: red neuronal especializada en detección y localización de objetos, utilizada para identificar elementos ofensivos o peligrosos.

-

MobileNet: arquitectura ligera optimizada para reconocer patrones culturales complejos como textiles tradicionales, iconografía religiosa o simbología local.

-

LLaMa 3.2 Instruct: modelo de PLN orientado a clasificar textos con alta sensibilidad al lenguaje de odio, acoso, estigmatización o desinformación.

-

Claude Sonnet: modelo multimodal con alta precisión en la moderación de contenido mixto (imagen + texto), útil para analizar publicaciones integradas.

-

APIs externas: como Azure Content Moderator y Google Cloud Vision, integradas como refuerzo adicional.

-

Fuentes de datos: utilizamos datasets públicos (Roboflow, Kaggle), scraping web (Wikimedia, Unsplash) y generación de imágenes sintéticas con Stable Diffusion bajo licencia comercial.

Resultados obtenidos

El sistema ha demostrado su eficacia y valor en entornos reales:

✅ Detección automatizada de 31 categorías de símbolos ofensivos y elementos inapropiados.

⚙️ Procesamiento por lotes de miles de imágenes en segundos, lo que permite escalar la revisión de contenido sin fricciones.

🔍 Mejora significativa de la protección reputacional, así como de la seguridad del entorno digital para marcas y comunidades.

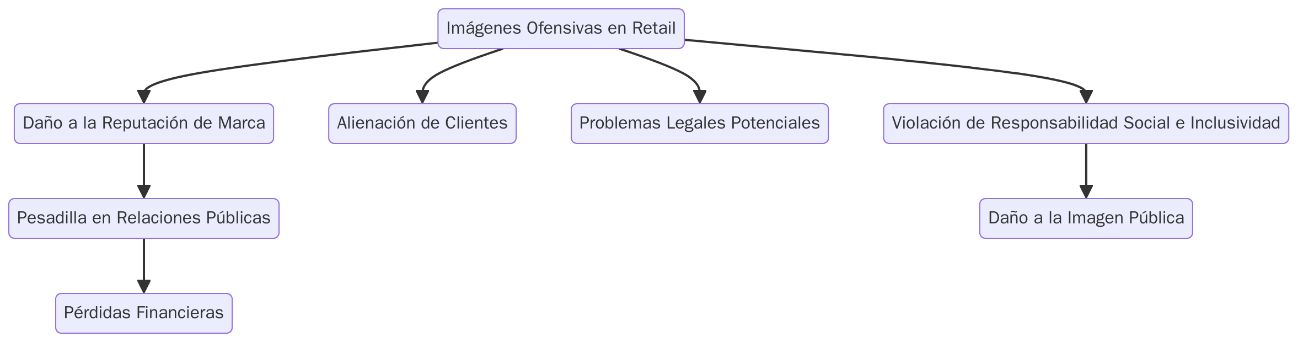

Por qué es importante

Una imagen malinterpretada o un mensaje fuera de lugar puede desencadenar una crisis reputacional inmediata, generar reacciones virales, provocar cancelaciones, boicots o incluso sanciones legales. En el caso de ONGs o plataformas sociales, los riesgos son aún más sensibles, ya que pueden afectar la confianza, la seguridad emocional y el bienestar de los usuarios.

Nuestra solución permite actuar con anticipación, minimizando riesgos y alineando el contenido publicado con los valores, normas y estándares éticos de cada organización. Es un sistema que no solo filtra lo problemático, sino que también permite comunicar con mayor responsabilidad, sensibilidad y coherencia cultural.

En hiberus, creemos firmemente que la tecnología debe estar al servicio del respeto, la inclusión y la integridad. Con esta plataforma de moderación de contenido, demostramos que es posible escalar procesos digitales sin perder el contexto humano, ayudando a las marcas y comunidades a proteger su imagen, construir entornos más seguros y fortalecer la confianza de sus audiencias.

Contamos con un equipo experto en IA Generativa y Data que han desarrollado GenIA Ecosystem, un ecosistema de soluciones propias de IA para afrontar cualquier desafío. ¡Cuéntanos tu proyecto!

¿Quieres más información sobre nuestros servicios de inteligencia artificial?

Contacta con nuestro equipo experto de Data e IA